27.6.1 System

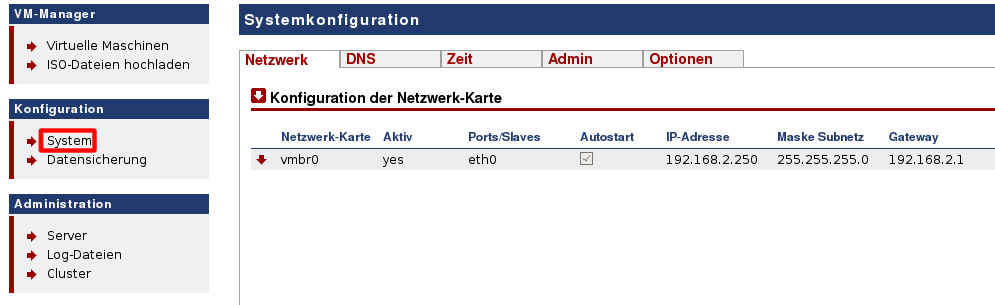

Unter diesem Menü-Punkt können Sie Einstellungen für ArchivistaVM vornehmen.

Viele der Optionen können Sie an mehreren Orten auf Ihrer ArchivistaBox festlegen. Die Einstellungen zur Netzwerk-Karte können Sie z.B. auch in WebConfig oder über das System-Menü vornehmen.

Viele der Optionen können Sie an mehreren Orten auf Ihrer ArchivistaBox festlegen. Die Einstellungen zur Netzwerk-Karte können Sie z.B. auch in WebConfig oder über das System-Menü vornehmen.